ReLu激活函数

时间:2015-04-24 14:02:48

收藏:0

阅读:10162

起源:传统激活函数、脑神经元激活频率研究

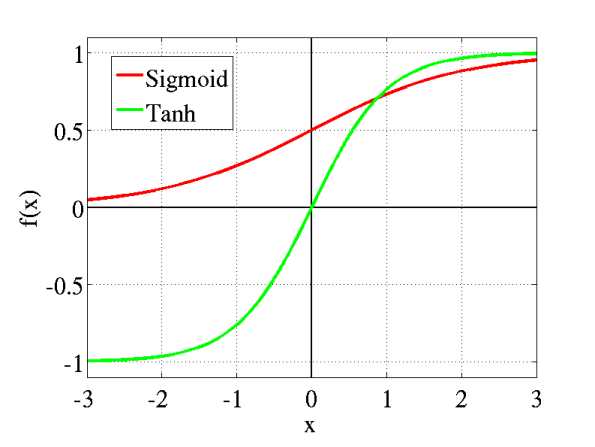

传统神经网络中最常用的两个激活函数,Sigmoid系(Logistic-Sigmoid、Tanh-Sigmoid)被视为神经网络的核心所在。

从数学上来看,非线性的Sigmoid函数对中央区的信号增益较大,对两侧区的信号增益小,在信号的特征空间映射上,有很好的效果。

从神经科学上来看,中央区区域酷似神经元的兴奋态,两侧区酷似神经元的抑制态,因而在神经网络学习方面,可以将重点特征推向中央区,将非重点特征推向两侧区。

无论是哪种解释,其实都比早期的线性激活函数(y=x),阶跃激活函数(-1/1,0/1)高明了不少。

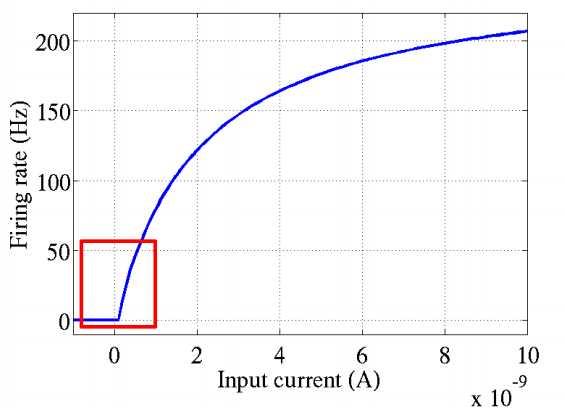

2001年,神经科学家Dayan and Abott模拟出了脑神经元接受信号更精确的激活模型,该模型如图所示:

这个模型

评论(0)